Kunstmatige intelligentie (AI) ontwikkelt zich snel en kan grote veranderingen veroorzaken in onze maatschappij. Kunstmatige intelligentie gebruiken biedt veel kansen, maar roept natuurlijk ook vragen op. Over bijvoorbeeld veiligheid, ethiek en privacy. Om die vragen te beantwoorden wordt in Brussel gewerkt aan de AI Act. Een Europese verordening die het op de markt brengen en het gebruik van AI moet gaan reguleren. In dit artikel gaat kernpartner Kennisnet in op deze nieuwe wet. Wat houdt de AI Act in en wat zijn de mogelijke gevolgen voor de onderwijssector?

Omdat de definitieve tekst van de AI Act nog niet vaststaat, kijken we naar de situatie zoals die nu bekend is.

Veilig en in overeenstemming met EU grondrechten

In april 2021 publiceerde de Europese Commissie het voorstel voor de AI Act. Deze nieuwe verordening heeft onder meer tot doel dat AI-systemen die in de EU in de handel worden gebracht en gebruikt, veilig zijn en in overeenstemming zijn met de grondrechten en waarden, zoals deze in de EU gelden.

Wat in de AI Act precies onder een AI-systeem wordt verstaan, is nog niet in beton gegoten. Er is ten opzichte van het oorspronkelijke wetsvoorstel behoorlijk gesleuteld aan de definitie. Het is belangrijk dat deze niet te ruim, maar ook niet te beperkt is. En ook technologieneutraal, zodat ook toekomstige vormen van AI eronder vallen.

Volgens de meest recente tekstvoorstellen is sprake van een AI-systeem als het gaat om een machinaal systeem dat is ontworpen om met verschillende niveaus van autonomie te werken, en dat voor expliciete of impliciete doelstellingen output kan genereren, zoals voorspellingen, aanbevelingen of beslissingen die van invloed zijn op de fysieke of virtuele omgeving. Allerlei toepassingen kunnen hieronder vallen, van chatbots tot zelfrijdende auto’s, van aanbevelingen in zoekmachines tot automatische gezichtsherkenningscamera’s.

AI Act kent een risicogebaseerde benadering

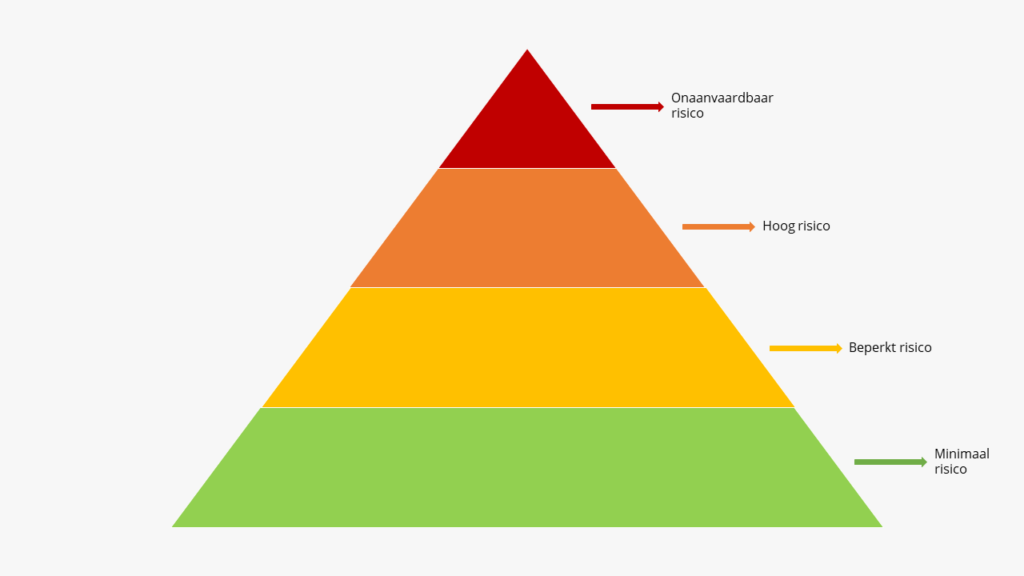

De AI Act kent een risicogebaseerde benadering: hoe hoger het risico van een AI-systeem, hoe meer verplichtingen er moeten worden nageleefd. Het risico wordt bepaald op basis van het beoogde doel van het gebruik van de technologie en de sector waarin deze wordt ingezet. Er worden vier risiconiveaus onderscheiden:

- Onaanvaardbaar risico

- Hoog risico

- Beperkt risico

- Minimaal risico

AI-systemen die in categorie 1, onaanvaardbaar risico, vallen worden in het voorstel verboden omdat deze schadelijk zijn en strijdig met de waarden van de EU. Het gaat hierbij om toepassingen die de meeste mensen te ver vinden gaan. Denk aan het gebruik van een social scoring systeem zoals in China wordt ingezet of realtime biometrische systemen voor identificatie op afstand in de openbare ruimte. Het voorstel is om ook emotiedetectie in bepaalde situaties, zoals op de werkvloer en in het onderwijs, onder deze verboden categorie op te nemen.

Het grootste deel van de bepalingen van de AI-Act richt zich op de tweede categorie: hoogrisico-systemen. Dit zijn AI-systemen die worden gebruikt in sectoren of contexten waar ze een risico kunnen vormen voor de gezondheid, veiligheid of grondrechten van personen. Voorbeelden zijn AI-systemen die worden gebruikt voor kritieke infrastructuur, werkgelegenheid, essentiële diensten (overheid en privaat), justitie, rechtshandhaving, migratie en onderwijs. Deze systemen moeten voldoen aan strenge eisen, waarop we verderop in dit artikel nader zullen ingaan.

Voor AI-systemen die vallen onder de beperkte risicocategorie gelden vooral transparantievereisten. Zodat de mensen weten dat ze met een AI-systeem te maken hebben. Denk hierbij aan het gebruik van chatbots door webshops of deep fakes.

Voor de laatste risico-categorie, minimaal risico, gelden er vanuit de AI Act geen verplichtingen. Hiervoor wordt alleen aanbevolen om gedragscodes op te stellen. Voorbeelden van AI-toepassingen onder deze categoriezijn spamfilters en AI in videogames.

Hoogrisico-AI-systemen in het onderwijs

In de AI act worden in het onderwijs gebruikte AI-toepassingen in bepaalde gevallen aangemerkt als hoogrisico-systemen. In de oorspronkelijke voorgestelde tekst van de AI Act ging het hierbij om AI-systemen voor het toelaten en beoordelen van leerlingen en studenten. Maar als de voorgestelde wijzigingen doorgaan, zullen hier ook adaptieve leermiddelen en fraudedetectiesystemen onder komen te vallen.

Wel wordt er een extra drempel ingebouwd: het AI-systeem moet een significant risico voor de gezondheid, veiligheid of grondrechten (zoals het recht op onderwijs of het recht niet gediscrimineerd te worden) vormen om als hoog risico te worden beschouwd. Er zullen door de Europese Commissie richtlijnen worden opgesteld om te specificeren in welke gevallen sprake is van een significant risico.

Hoewel de exacte tekst van de AI Act nog niet vaststaat en de interpretatie van significant risico nog niet geheel duidelijk is, is het goed mogelijk dat bepaalde toepassingen die in het funderend onderwijs worden gebruikt, kunnen worden gekwalificeerd als hoogrisico-AI-systemen. AI wordt op dit moment al gebruikt in bepaalde adaptieve leermiddelen. Waarbij het systeem aan de hand van algoritmen bepaalt wat het niveau van de leerling is. Het systeem stemt de aangeboden lesstof daarop af.

Als zo’n systeem verkeerd is ontworpen of onjuist wordt gebruikt, zou een leerling ten onrechte leerstof aangeboden kunnen krijgen op een niveau dat niet passend is. Het is denkbaar dat er situaties zijn waarin het gebruik van dergelijke toepassingen als een significant risico voor de grondrechten van een leerling kan worden beschouwd. Zeker wanneer er verder geen menselijk controle zou plaatsvinden.

Verplichtingen bij hoogrisico-systemen

Welke verplichtingen er gelden, hangt af van de rol die een partij in de AI-keten inneemt. De AI Act legt de meeste verplichtingen neer bij de ontwikkelaars van AI-systemen, die in de wet ‘aanbieders’ worden genoemd. Als zij een AI-systeem dat onder een hoogrisico-categorie valt op de markt willen brengen, moeten zij voldoen aan diverse eisen. Zoals het zorgen voor een kwaliteitsbeheersysteem voor aantoonbare compliance met de AI Act, het verstrekken van technische documentatie en transparante informatie, registratie van het systeem in een publieke database, het melden van ernstige storingen en incidenten, en het opstellen van een conformiteitsverklaring dat het AI-systeem aan de AI Act voldoet.

Scholen zullen over het algemeen zelf niet de aanbieder, maar de gebruiker van een AI-systeem zijn. Organisaties die AI-systemen gebruiken worden in Nederlandse vertaling van de AI Act ‘exploitanten’ genoemd (de Engelstalige term is deployers). Ook voor exploitanten gelden er verplichtingen bij hoogrisico-toepassingen. Zo moeten zij:

- AI-systemen gebruiken in overeenstemming met de gebruiksaanwijzing

- zorgen dat de inputdata relevant en voldoende representatief is voor het beoogde doel

- menselijk toezicht uitoefenen op het AI-systeem

- logbestanden bewaren

- personen informeren over wie besluiten worden gemaakt met behulp van AI

- een Fundamental Rights Impact Assessment (FRIA) uitvoeren (deze verplichting komt naast de verplichting van een DPIA wanneer persoonsgegevens worden verwerkt).

Als scholen exploitant zijn van een AI-systeem dat als hoogrisico-toepassing kan worden gekwalificeerd, dan gelden deze verplichtingen dus ook voor hen.

Wanneer gaat de nieuwe wet in?

Op dit moment ligt de tekst van de AI Act nog niet vast. Zowel de Raad van de EU als het Europees Parlement hebben ruim 3.000 amendementen voorgesteld op het voorstel van de Europese Commissie. Op 14 juni heeft het Europees Parlement overeenstemming bereikt over haar wijzigingen. De komende maanden zullen de zogenaamde trialogen plaatsvinden. Het deel van het wetgevingsproces waarbij de partijen met elkaar onderhandelen over de definitieve tekst. Naar verwachting wordt voor het einde van 2023 een compromis bereikt over de AI Act. En zal deze halverwege 2024 in werking treden. Daarna krijgen organisaties 2 jaar de tijd om de nieuwe wet te implementeren.

Kennisnet volgt de ontwikkelingen rond de AI Act op de voet. Wanneer meer duidelijkheid over de definitieve tekst, analyseren we wat de impact is van deze nieuwe wetgeving op het funderend onderwijs.

Lees ook:

- AI wint prijzen, spreekt af met kinderen en imiteert zangers: ‘Snel meer regels nodig’

- Hype, of het nieuwe Google? ChatGPT leert ons veel over kunstmatige intelligentie

- Een overzicht van alle artikelen over kunstmatige intelligentie op NetwerkMediawijsheid.nl

- Maakt schrijvende AI straks huiswerk overbodig?

- Dossier over kunstmatige intelligentie op Mediawijsheid.nl

Reacties worden eerst goedgekeurd door de redactie.